随着短视频的大火,不仅可以给人们带来娱乐,还有热点新闻时事以及各种知识,刷短视频也逐渐成为了日常生活的一部分。本文以一个简单的小例子,简述如何通过Pyhton依托Selenium来爬取短视频,仅供学习分享使用,如有不足之处,还请指正。

涉及知识点

- selenium,作为浏览器端一个自动化测试工具,可以模拟用户操作浏览器的动作,就像是人自己操作浏览器一样。关于selenium的具体信息如下

- Selenium进行元素定位,主要有ID,Name,ClassName,Css Selector,Partial LinkText,LinkText,XPath,TagName等8种方式。

- Selenium获取单一元素(如:find_element)和获取元素数组(如:find_elements)两种方式。

- Selenium元素定位后,可以给元素进行赋值和取值,或者进行相应的事件操作(如:click)。

- requests,web请求对象,通过selenium获取到视频的url后,再通过requests库进行视频流的获取,然后保存成本地视频文件。

- 浏览器开发者工具,通过开发者工具可以查看页面上某一个按钮或链接等页面元素对应的html标识。

目标分析

在爬取视频之前,需要分析目标结构,本视频爬取分析可分为三步,具体如下所示:

1. 分析热榜目录

热榜目录是一个ul标签,每一个热榜对象一个li子标签,分别包含热度,标题等内容。点击标题链接可以进入具体视频播放页面,目标分析如下所示:

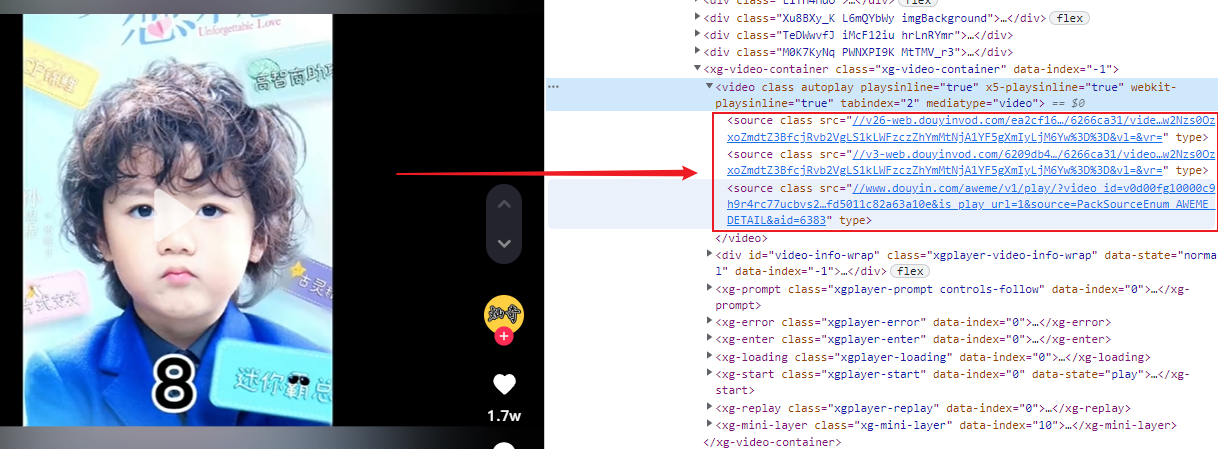

2.分析视频播放页面

视频在video标签中播放,短视频播放的真实地址,在video的source子标签中,且为了保证播放质量,video下有三个source,任取其一即可,如下所示:

3. 分析弹出框

在爬取过程中,经过弹出需要登录的窗口,需要及时关闭掉,否则可能会导致找不到页面元素,从而爬取不成功。如下所示:

核心代码

经过以上分析,就可以编写爬虫代码了,如下所示:

1. 遍历热点目录

通过获取页面上对应的信息,解析出热点视频的目录,如下所示:

1 self.__driver.get(self.__url) 2 self.close_popup_window() 3 # 4. 最大化窗口 4 self.__driver.maximize_window() 5 time.sleep(self.__wait_sec) 6 # 打开以后,根据class=BHgRhxNh获取ul下的li 7 if self.checkIsExistsByClass(cls=\'BHgRhxNh\'): 8 # 获取 9 hots = self.__driver.find_elements(by=By.CLASS_NAME, value=\'BHgRhxNh\') 10 hot_infos = [] 11 index = 0 12 for hot in hots: 13 hot_info = {} 14 a = hot.find_element(by=By.TAG_NAME, value=\'a\') 15 href = a.get_attribute(\"href\") 16 text = a.text 17 hot_info[\'url\'] = href 18 hot_info[\'text\'] = text 19 if index > 0: 20 div = hot.find_element(by=By.CLASS_NAME, value=\'GsuT_hjh\') 21 if div is not None: 22 hot_value = div.find_element(by=By.TAG_NAME, value=\'span\').text 23 hot_info[\'value\'] = hot_value 24 hot_infos.append(hot_info) 25 index = index + 1 26 print(hot_infos)

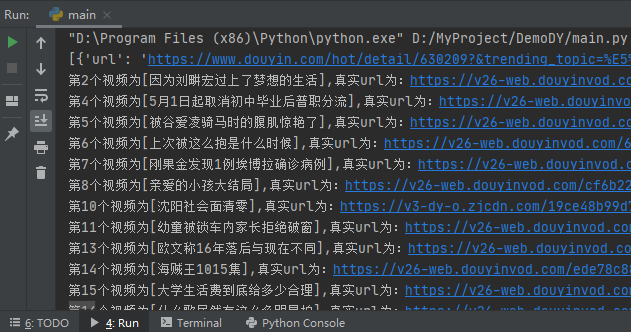

2. 获取真实短视频url

打开单个热点视频的url,并解析真实短视频播放url,如下所示:

1 def open_video_html(self, url): 2 \"\"\"打开具体视频的页面\"\"\" 3 self.__driver.get(url=url) 4 time.sleep(1) 5 self.close_popup_window() # 关闭弹窗 6 video = self.__driver.find_element(by=By.TAG_NAME, value=\'video\') 7 source = video.find_element(by=By.TAG_NAME, value=\'source\') 8 src = source.get_attribute(\'src\') 9 return src

3. 下载视频

获取真实的url后,即可进行下载,如下所示:

1 def download_video(self, url, video_name): 2 \"\"\"根据视频源地址进行下载\"\"\" 3 if os.path.exists(video_name): 4 # 如果已重新下载过,则不需要再次下载 5 return 6 else: 7 with open(video_name, \'wb\') as fp: 8 fp.write(requests.get(url).content)

4. 关闭弹出的登录窗口

在爬取过程中,经常弹出需要登录的遮罩窗口,需要进行关闭,如下所示:

1 def close_popup_window(self): 2 try: 3 login = self.__driver.find_element(by=By.ID, value=\'login-pannel\') 4 if login is not None: 5 login.find_element(by=By.CLASS_NAME, value=\'dy-account-close\').click() 6 except BaseException as e: 7 pass 8 try: 9 login = self.__driver.find_element(by=By.CLASS_NAME, value=\'GaDkStRD\') 10 if login is not None: 11 btns = login.find_elements(by=By.TAG_NAME, value=\'button\') 12 for btn in btns: 13 if btn.text == \'取消\': 14 btn.click() 15 break 16 except BaseException as e: 17 pass

5. 保存日志

在爬取成功后,对爬取的短视频的相关内容进行保存,如下所示:

1 def save_data(self, hot_infos): 2 \"\"\" 3 保存数据 4 :param res_list: 保存的内容文件 5 :return: 6 \"\"\" 7 t = time.strftime(\"%Y-%m-%d\", time.localtime()) 8 with open(f\'logs[{t}].json\', \'a\', encoding=\'utf-8\') as f: 9 res_list_json = json.dumps(hot_infos, ensure_ascii=False) 10 f.write(res_list_json)

示例截图

程序开发完成后,运行示例如下所示:

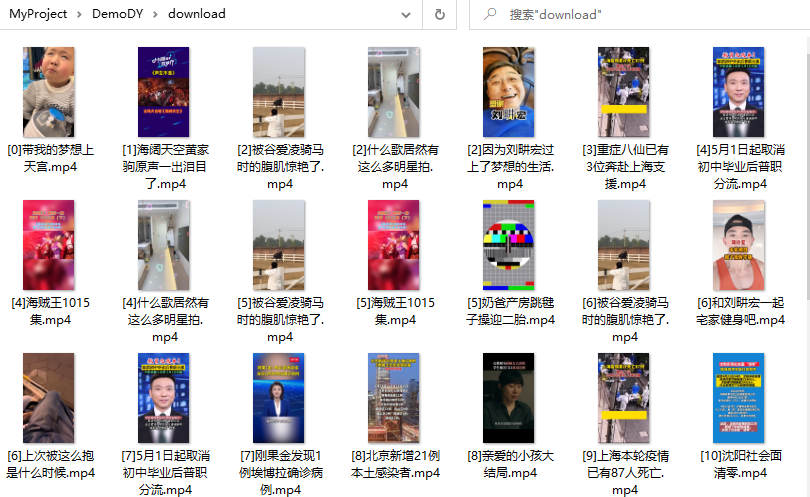

爬取的视频保存在download目录下,如下所示:

总结

为什么会采用selenium进行本次短视频的爬取,而不直接采用requests库,原因如下:

- 在对目标网站进行分析的过程中,发现目标网站采用异步调用的方式数据获取,即网址请求获取的只是空壳,并没有真实的数据。

- 在对异步接口调用的url进行分析时发现,很多接口的url都具有时效性及有效性验证,如token,时间戳等,构造起来相当麻烦。

由于以上两点原因,结合selenium的特点及优势,所以最终采用selenium进行此次爬虫的最佳选择。

备注

以上就是本次爬取短视频的全部内容,仅供学习分享使用,不足之处,还请指正。

菩萨蛮·书江西造口壁【作者】辛弃疾

郁孤台下清江水,中间多少行人泪?西北望长安,可怜无数山。

青山遮不住,毕竟东流去。江晚正愁余,山深闻鹧鸪。

作者:小六公子

出处:http://www.cnblogs.com/hsiang/

本文版权归作者和博客园共有,写文不易,支持原创,欢迎转载【点赞】,转载请保留此段声明,且在文章页面明显位置给出原文连接,谢谢。

关注个人公众号,定时同步更新技术及职场文章

来源:https://www.cnblogs.com/hsiang/p/16192686.html

本站部分图文来源于网络,如有侵权请联系删除。

百木园

百木园